Vitis AI

- デザイン ツール

- Vitis 統合ソフトウェア プラットフォーム

- Vitis AI

エッジからクラウドまでに対応する AI 推論

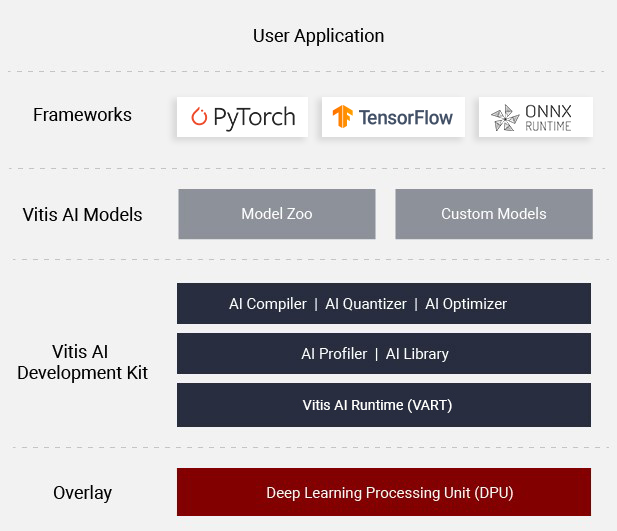

Vitis™ AI ソフトウェアは、AMD のデバイス、ボード、Alveo™ データセンター アクセラレーション カード、特定 PC、ラップトップ、およびワークステーション向けの包括的な AI 推論開発ソリューションです。豊富な AI モデル、最適化された DPU (深層学習プロセッシング ユニット) コア、ツール、ライブラリ、サンプル デザインを利用でき、エッジ、エンドポイント、データセンターで使用する AI アプリケーションに対応できます。Vitis AI は、高い効率性と使いやすさを考えて設計されており、AMD アダプティブ SoC や Ryzen™ AI 搭載 PC での AI アクセラレーションや深層学習のパフォーマンスを最大限に引き出すことができます。

図 1 - Vitis AI の構造

Vitis AI ソフトウェアを使用する開発のメリット

- 多様な深層学習推論、CNN、および生成系の大規模言語モデルに対応できる主要フレームワークと最新モデルをサポート

- クオンタイザーおよびオプティマイザー ツールを使用して、モデルの精度や処理効率を最適化

- シンプルなコンパイル フローと高レベル API を使用して、カスタム モデルの迅速な運用が可能

- 高効率でカスタマイズ可能な DPU コアを使用して、スループット、レイテンシ、消費電力など、エッジ、エンドポイント、クラウドのさまざまな要件に対応可能

Vitis AI がもたらす可能性

図 2 - Model Zoo

AI Model Zoo

AI Model Zoo は、すべてのユーザーを対象に PyTorch、TensorFlow、ONNX で構築した、すぐに使える深層学習モデルを豊富に提供しています。この AI Model Zoo では、最適化済みの再トレーニング可能な AI モデルを提供しています。これらを利用することで、AMD プラットフォーム上で効率的に AI 開発が可能になり、高速化されたデザインをすばやく構築して製品化できます。

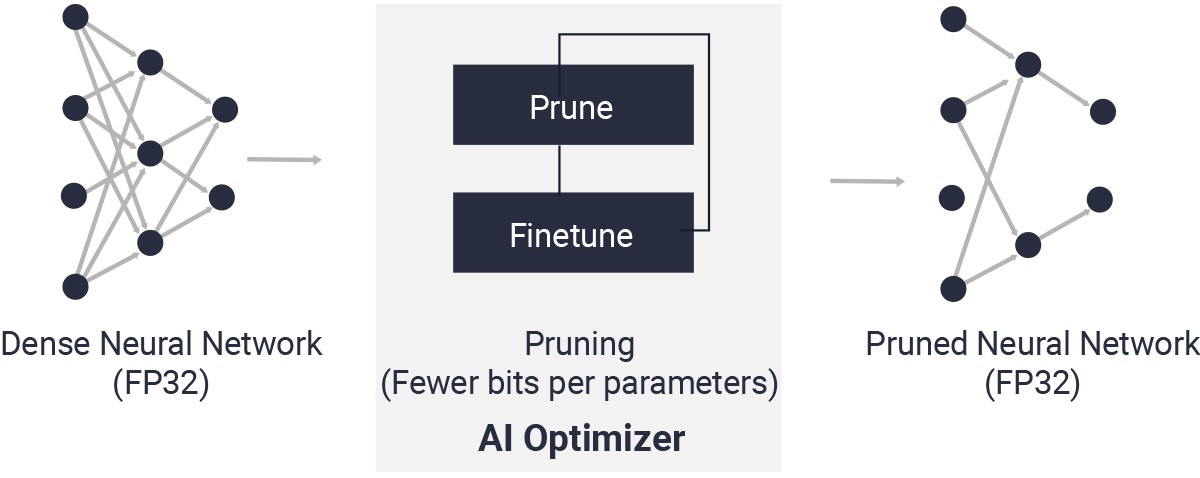

AI オプティマイザー

優れたモデル圧縮技術により、AI オプティマイザーで精度への影響を最小限に抑えながら、複雑なモデルを 1/5 から最大 1/50 まで圧縮できます。Deep Compression で次世代レベルの AI 推論性能が実現します。

図 3 - Vitis AI オプティマイザー

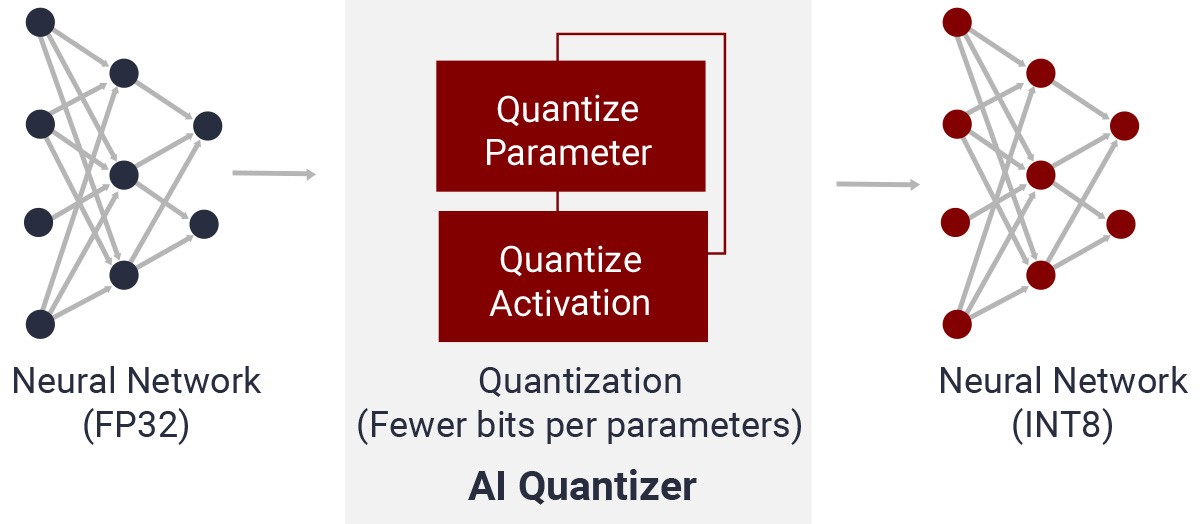

図 4 - Vitis AI クオンタイザー

AI クオンタイザー

カスタム演算子の検査、量子化、キャリブレーション、微調整、および浮動小数点モデルから固定小数点モデルへの変換などのプロセスによって、狭いメモリ帯域幅で、より高速かつ高効率な演算処理が可能になります。

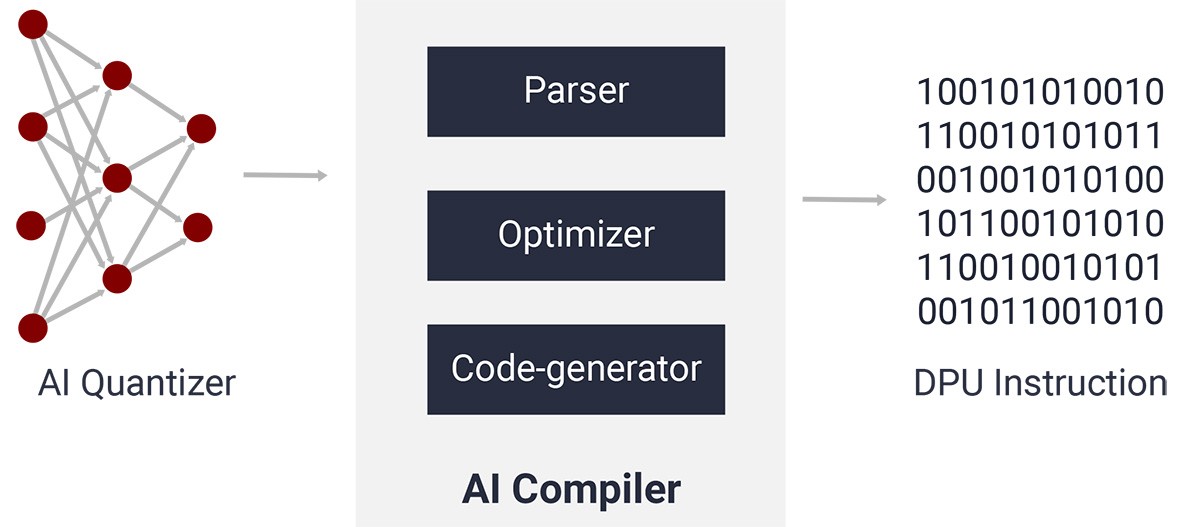

AI コンパイラ

AI コンパイラは、AI モデルを効率の高い命令セットとデータフローにマップします。また、レイヤーの融合や命令スケジューリングなどの高度な最適化を実行し、オンチップ メモリを可能な限り再利用します。

図 5 - Vitis AI コンパイラ

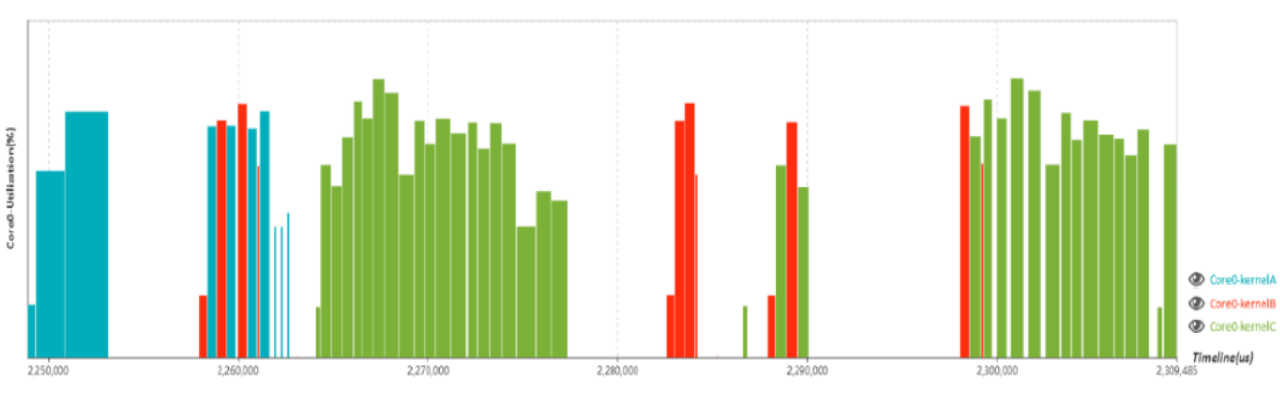

AI プロファイラー

パフォーマンス プロファイラーでは、AI 推論実装における効率性と使用率を詳細に分析できます。

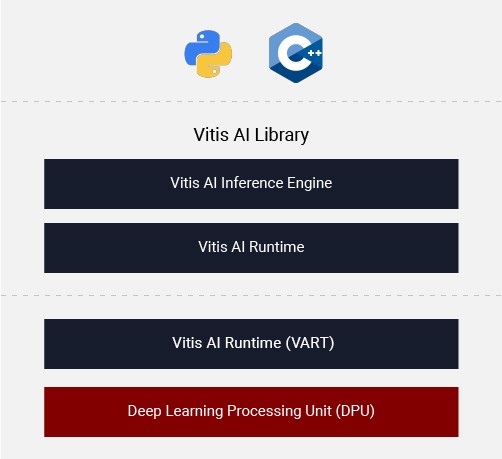

AI ライブラリ

Vitis AI ライブラリは、DPU コアを使用して効率的な AI 推論を実現するために構築された高レベルのライブラリと API です。統合 API を備える Vitis AI ランタイム (VART) をベースに構築されており、AMD プラットフォームで AI モデルを運用するのに最適なインターフェイスを提供します。

図 7 - Vitis AI ライブラリ

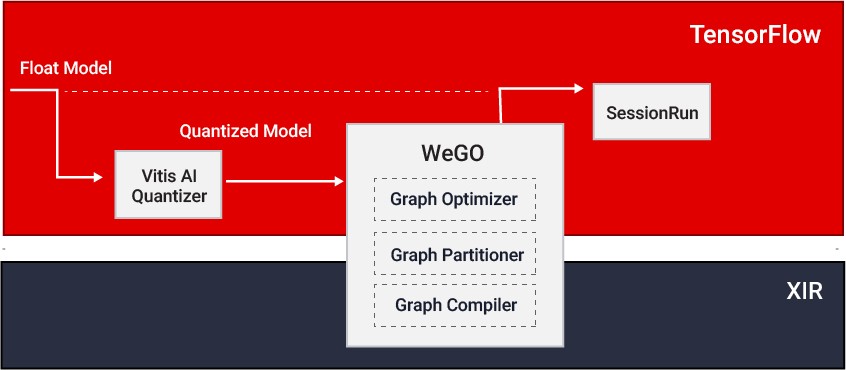

図 8 - Vitis AI コンパイラ

WeGO (Whole Graphic Optimizer)

WeGO フレームワーク対応の推論フローは、ネイティブの Pytorch または Tensorflow フレームワークを活用して学習から推論までのシンプルなパスを提供します。DPU でサポートされていない演算子を CPU にマップすることでクラウド DPU 上でのモデルの運用や評価を大幅に高速化できます。

深層学習プロセッシング ユニット (DPU)

DPU とは、急速に進化する CNN および Transformer ベースの AI アルゴリズムに対応できる適応型のドメイン固有アーキテクチャ (DSA) であり、AMD アダプティブ SoC、Alveo データセンター アクセラレータ カード、および一部の Ryzen AI 搭載 PC に実装することで業界最高クラスのパフォーマンスを達成できます。

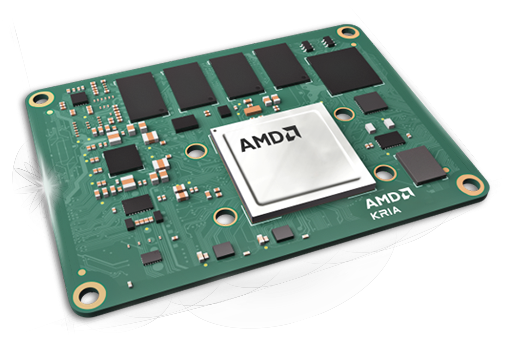

エッジで運用

Vitis™ AI ソフトウェアは、エッジ デバイス向けの最適なアルゴリズムを提供することで高性能コンピューティングを実現できる上、運用時の柔軟性向上と省電力化も可能になります。自動車、産業、医療、ビデオ解析など、一般的なエッジ アプリケーションに高い演算性能をもたらします。

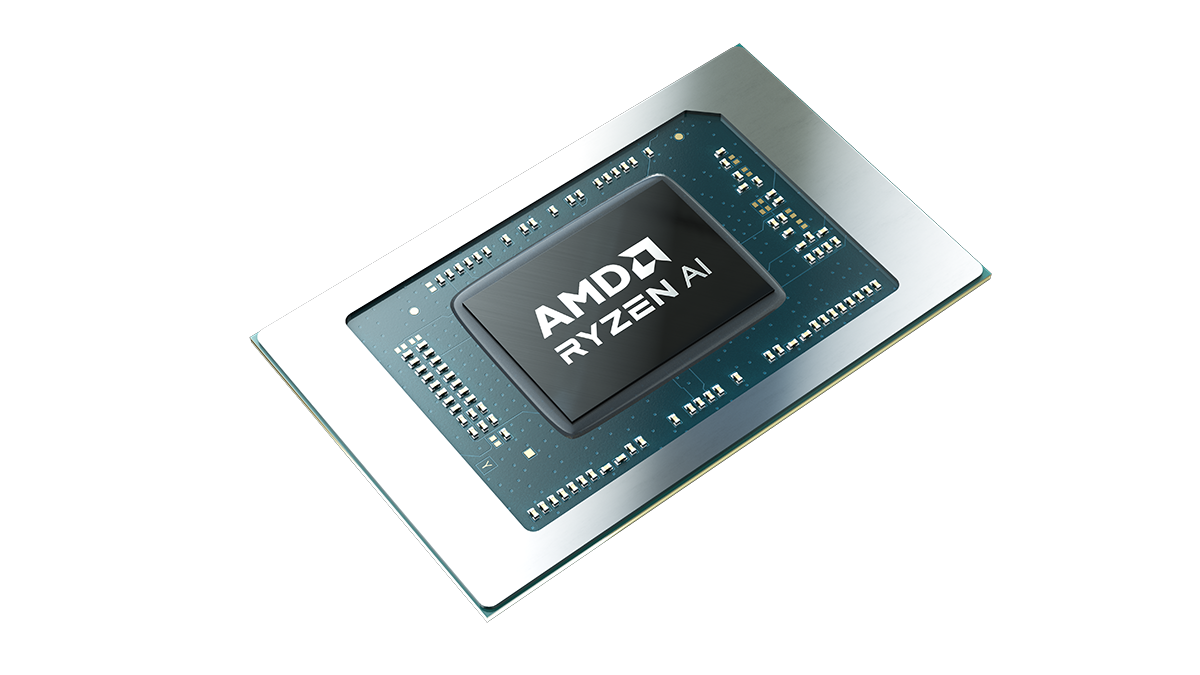

クライアントで運用

AMD Ryzen™ 7040 シリーズ モバイル プロセッサは、AMD XDNA™ アーキテクチャを採用しており、マルチタスクの高速化、生産性と効率性の向上、高度な連携を可能にします。

オンプレミスで運用

AMD の Alveo™ データセンター アクセラレータ カードで Vitis AI を活用することで、CNN、RNN、NLP などのさまざまなワークロードに対して競争力の高い AI 推論性能を実現できます。これらのオンプレミス AI ソリューションは、最先端データセンターで求められる超低レイテンシかつ高スループットを実現し、柔軟性を備えることができます。CPU や GPU よりも高い演算性能を提供し、TCO も削減できます。

クラウドで運用

AMD は、AWS や VMAccel などのパブリック クラウド サービス プロバイダーと連携することで、FPGA や Versal™ アダプティブ SoC クラウド インスタンスへのリモート アクセスを可能にしています。これにより、ローカルにハードウェアやソフトウェアがなくても、すばやく簡単にモデルを構築して運用できます。

Vitis AI プラットフォーム資料

モデル、ツール、深層学習プロセッシング ユニット (DPU) など、Vitis™ AI プラットフォームを使用する開発に役立つ豊富な資料を提供しています。

次のリンクから資料をご覧いただくか、またはすべての Vitis AI プラットフォーム資料を資料ポータルでご覧ください。

自動運転および ADAS 技術を強化

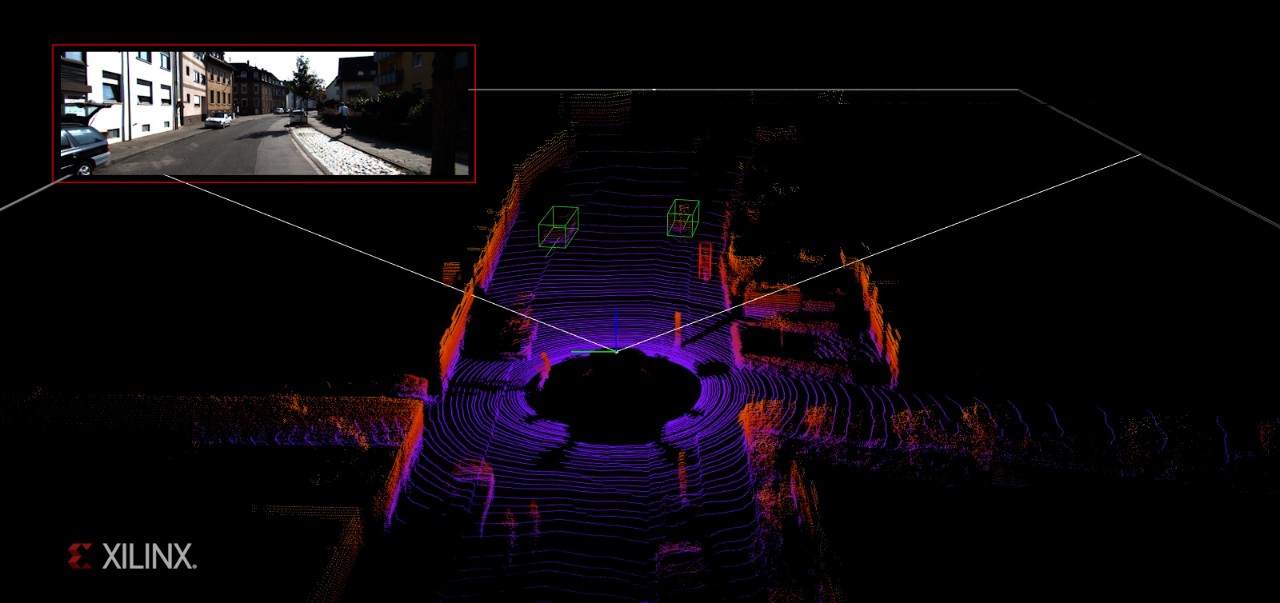

リアルタイム マルチクラス 3D 物体認識

Vitis™ AI 環境では、エンベデッド プラットフォームに 3D 知覚の AI アルゴリズムを実装することで、リアルタイム処理を実現できます。HW と SW の協調最適化により、AMD の Zynq™ UltraScale+™ MPSoC で最先端 PointPillars モデルのパフォーマンスを最大限に引き出します。

ビデオを表示 >

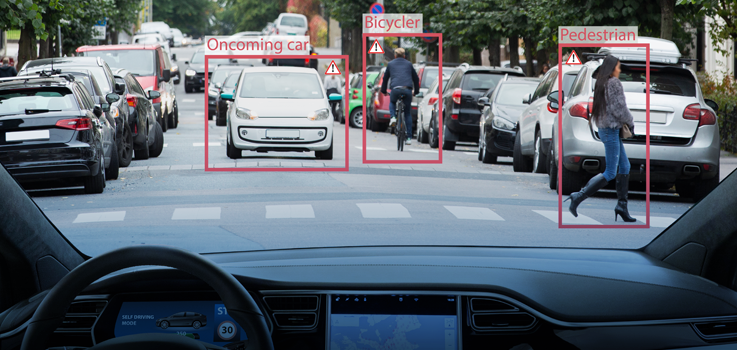

自動運転向けの超低レイテンシ アプリケーション

自動運転車が高速で走行し、障害物に遭遇するとき、レイテンシは意思決定において致命的な要素となります。革新的な特定用途向けのアクセラレータと最適化済みソフトウェアを利用できる Vitis AI 環境では、高性能でありながら超低レイテンシで深層学習アルゴリズムを処理する自動運転車向けのアプリケーションを実現できます。

物体検出とセグメンテーション

ローエンドからハイエンドまでのあらゆる ADAS 製品に適合する優れた拡張性と適応性を提供する Vitis AI では、フロント ADAS、インキャビン、サラウンド ビュー システムにおけるオブジェクト検出、車線検出、セグメンテーションの一般的な AI アルゴリズムを提供し、業界最高性能を実現できます。

よりスマートで安全な街を創る

ビデオ解析

都市部では、エッジ ポイントやクラウド エンドでインテリジェンス機能を備えたシステムを導入するようになりました。大量のデータが毎日生成されるようになり、物体、トラフィック、顔の動きをすばやく検出して処理するためには、エンドツーエンドの高性能 AI 分析システムが必要です。これにより、エッジからクラウドまでの各フレームに有益なインサイトが追加されます。

AI 機能による革新的なヘルスシステムの実現

画像処理、診断、治療用機器向けの AI

Vitis AI は、医用画像データに潜むパターンを検出して特定し、病気の克服や健康向上に役立つ画期的なツールおよび IP を提供します。

AMD ヘルスケア AI の詳細 >

オンプレミスおよびデータセンターの AI

データセンター アクセラレーション

特集ビデオ

すべてのビデオ

開発を開始

エンベデッド プラットフォームを使用する開発

ステップ 1: ハードウェア プラットフォームを設定する

ステップ 2: GitHub から Vitis AI™ 環境をダウンロードおよびインストールする

ステップ 3: VART および AI ライブラリを使用して Vitis AI 環境サンプルを実行する

ステップ 4: チュートリアル、ビデオなどにアクセスする

エンベデッド プラットフォームを使用する開発の詳細は、次のボタンをクリックしてください。

Ryzen™ AI を使用する開発

Ryzen AI ソフトウェアで開発を始める

- インストール

- 開発フロー

- Getting Started: サンプル、デモ、チュートリアル

Ryzen AI ソフトウェアを使用する開発の詳細は、次のボタンをクリックしてください。